Owen Little

0

5225

490

Si vous exploitez un site Web 10 façons de créer un site Web petit et simple sans surcharge excessive 10 façons de créer un site Web petit et simple sans perte excessive WordPress peut être excessif. Comme le prouvent ces autres excellents services, WordPress n’est pas la solution idéale pour la création de sites Web. Si vous souhaitez des solutions plus simples, vous avez le choix entre plusieurs solutions. , vous avez probablement entendu parler d’un fichier robots.txt (ou du “norme d'exclusion des robots”) Que vous l'ayez ou non, il est temps d'en apprendre davantage, car ce simple fichier texte est une partie cruciale de votre site. Cela peut sembler anodin, mais vous pourriez être surpris de voir à quel point il est important.

Jetons un coup d'oeil à ce qu'est un fichier robots.txt, ce qu'il fait et comment le configurer correctement pour votre site.

Qu'est-ce qu'un fichier robots.txt?

Pour comprendre le fonctionnement d'un fichier robots.txt, vous devez connaître un peu les moteurs de recherche. Comment fonctionnent les moteurs de recherche? Comment fonctionnent les moteurs de recherche? Pour beaucoup de gens, Google est l’internet. C'est sans doute l'invention la plus importante depuis Internet. Et bien que les moteurs de recherche aient beaucoup changé depuis, les principes sous-jacents sont toujours les mêmes. . La version courte est qu'ils envoient “chenilles,” qui sont des programmes qui parcourent Internet pour trouver des informations. Ils stockent ensuite une partie de cette information pour pouvoir y diriger les gens plus tard..

Ces chenilles, également connues sous le nom de “bots” ou “les araignées,” trouver des pages de milliards de sites Web. Les moteurs de recherche leur indiquent où aller mais les sites Web individuels peuvent également communiquer avec les robots et leur indiquer les pages qu'ils devraient consulter..

La plupart du temps, ils font en fait le contraire et leur disent quelles pages ils ont ne devrait pas être en train de regarder. Des éléments tels que les pages administratives, les portails principaux, les catégories et les balises, ainsi que d'autres éléments que les propriétaires de sites ne souhaitent pas afficher sur les moteurs de recherche. Ces pages sont toujours visibles par les utilisateurs et accessibles à toute personne ayant la permission (qui est souvent tout le monde)..

Mais en disant à ces araignées de ne pas indexer certaines pages, le fichier robots.txt rend service à tout le monde. Si vous avez cherché “Se servir de” sur un moteur de recherche, voudriez-vous que nos pages administratives apparaissent en haut du classement? Non, cela ne ferait aucun bien, alors nous disons aux moteurs de recherche de ne pas les afficher. Il peut également être utilisé pour empêcher les moteurs de recherche de consulter des pages susceptibles de ne pas les aider à classer votre site dans les résultats de recherche..

En bref, robots.txt indique aux crawlers web ce qu’il faut faire..

Les robots peuvent-ils ignorer le fichier robots.txt?

Les robots d'exploration ignorent-ils les fichiers robots.txt? Oui. En fait, beaucoup de chenilles faire l'ignorer. Toutefois, ces robots ne proviennent généralement pas de moteurs de recherche réputés. Ils proviennent de spammeurs, de récupérateurs de courrier électronique et d'autres types de robots automatisés qui parcourent Internet. Il est important de garder cela à l'esprit - utiliser la norme d'exclusion des robots pour empêcher les robots de rester à l'écart n'est pas une mesure de sécurité efficace. En fait, certains robots pourraient début avec les pages que vous leur dites de ne pas aller à.

Les moteurs de recherche feront cependant comme le dit votre fichier robots.txt tant qu'il est correctement formaté.

Comment écrire un fichier robots.txt

Un fichier standard d'exclusion de robot contient plusieurs parties différentes. Je vais les décomposer chacun individuellement ici.

Déclaration de l'agent utilisateur

Avant de dire à un bot quelles pages il ne devrait pas regarder, vous devez spécifier à quel bot vous parlez. La plupart du temps, vous utiliserez une simple déclaration qui signifie “tous les bots.” Cela ressemble à ceci:

Agent utilisateur: *L'astérisque remplace “tous les bots.” Vous pouvez cependant spécifier des pages pour certains robots. Pour ce faire, vous devez connaître le nom du bot pour lequel vous établissez des directives. Cela pourrait ressembler à ceci:

Agent utilisateur: Googlebot [liste des pages à ne pas analyser] Agent utilisateur: Googlebot-Image / 1.0 [liste des pages à ne pas analyser] Agent utilisateur: Bingbot [liste des pages à ne pas analyser]Etc. Si vous découvrez un bot que vous ne voulez pas du tout explorer votre site, vous pouvez également le spécifier..

Pour trouver les noms des agents utilisateurs, consultez useragentstring.com [N'est plus disponible].

Refuser les pages

C'est la partie principale de votre fichier d'exclusion de robot. Avec une simple déclaration, vous dites à un bot ou à un groupe de robots de ne pas explorer certaines pages. La syntaxe est facile. Voici comment interdire l'accès à tout ce qui se trouve dans le “admin” répertoire de votre site:

Interdit: / admin /Cette ligne empêchera les bots d’explorer yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html et tout ce qui se trouve dans le répertoire admin..

Pour interdire une seule page, spécifiez-la simplement dans la ligne interdire:

Interdit: /public/exception.htmlMaintenant le “exception” page ne sera pas tirée, mais tout le reste dans le “Publique” dossier sera.

Pour inclure plusieurs annuaires ou pages, il suffit de les lister sur les lignes suivantes:

Interdit: / privé / Interdit: / admin / Interdit: / cgi-bin / Interdit: / temp /Ces quatre lignes s’appliqueront à l’agent utilisateur que vous avez spécifié en haut de la section..

Si vous voulez empêcher les robots de regarder une page de votre site, utilisez ceci:

Interdit: /Fixer différentes normes pour les bots

Comme nous l'avons vu ci-dessus, vous pouvez spécifier certaines pages pour différents robots. En combinant les deux éléments précédents, voici à quoi cela ressemble:

Agent utilisateur: googlebot Interdit: / admin / Interdit: / privé / Agent utilisateur: bingbot Interdit: / admin / Interdit: / privé / Interdit: / secret /le “admin” et “privé” sections seront invisibles sur Google et Bing, mais Google verra le “secret” répertoire, alors que Bing ne sera pas.

Vous pouvez spécifier des règles générales pour tous les robots en utilisant l'agent utilisateur astérisque, puis donner des instructions spécifiques aux robots dans les sections suivantes..

Mettre tous ensemble

Avec les connaissances ci-dessus, vous pouvez écrire un fichier robots.txt complet. Lancez votre éditeur de texte préféré (nous sommes fans de Sublime 11 Astuces Sublime Text pour une productivité accrue et un flux de travail plus rapide. 11 Astuces Sublime Text pour une productivité et un flux de production plus rapides. Sublime Text est un éditeur de texte polyvalent et un standard de référence pour de nombreux programmeurs. Les conseils se concentrent sur l'efficacité du codage, mais les utilisateurs généraux apprécieront les raccourcis clavier (ici) et commenceront à faire savoir aux robots qu'ils ne sont pas les bienvenus dans certaines parties de votre site..

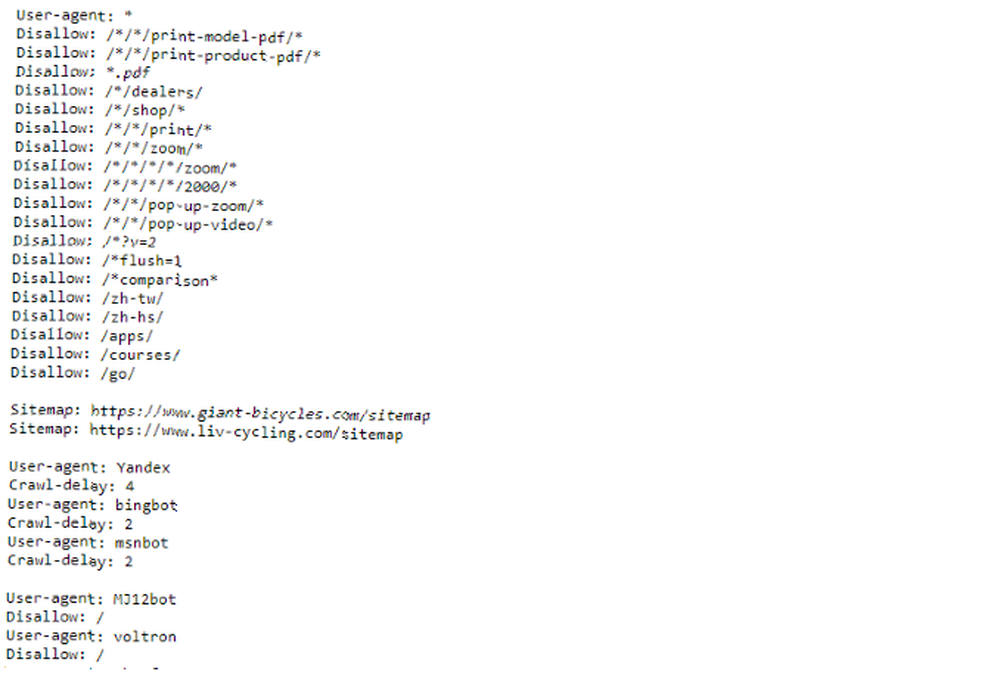

Si vous souhaitez voir un exemple de fichier robots.txt, rendez-vous sur n’importe quel site et ajoutez “/robots.txt” jusqu'à la fin. Voici une partie du fichier robots.txt de Giant Bicycles:

Comme vous pouvez le constater, ils ne veulent pas que certaines pages apparaissent dans les moteurs de recherche. Ils ont également inclus quelques éléments dont nous n'avons pas encore parlé. Voyons ce que vous pouvez faire d'autre dans votre fichier d'exclusion de robot.

Localisation de votre sitemap

Si votre fichier robots.txt indique aux bots où ne pas Pour créer un sitemap XML en 4 étapes simples Comment créer un sitemap XML en 4 étapes simples Il existe deux types de sitemaps: une page HTML ou un fichier XML. Un plan du site HTML est une page unique qui montre aux visiteurs toutes les pages d'un site Web. Il contient généralement des liens vers ceux-ci… et les aide à trouver ce qu'ils cherchent. Et même si les moteurs de recherche savent probablement déjà où se trouve votre plan de site, il n’est pas inutile de leur faire savoir à nouveau..

La déclaration d'un emplacement de sitemap est simple:

Plan du site: [URL du plan du site]C'est tout.

Dans notre propre fichier robots.txt, cela ressemble à ceci:

Plan du site: //www.makeuseof.com/sitemap_index.xmlC'est tout ce qu'on peut en dire.

Définition d'un délai d'analyse

La directive crawl delay indique à certains moteurs de recherche combien de fois ils peuvent indexer une page de votre site. Il est mesuré en secondes, bien que certains moteurs de recherche l’interprètent légèrement différemment. Certains voient dans un délai d'analyse de 5 le temps d'attendre cinq secondes après chaque analyse pour lancer la suivante. D'autres l'interprètent comme une instruction de ne parcourir qu'une page toutes les cinq secondes.

Pourquoi voudriez-vous dire à un robot de ne pas ramper autant que possible? Pour préserver la bande passante, 4 façons dont Windows 10 gaspille votre bande passante Internet et 4 façons Windows 10 gaspille votre bande passante Internet Windows 10 gaspille-t-il votre bande passante Internet? Voici comment vérifier et ce que vous pouvez faire pour l'arrêter. . Si votre serveur a du mal à gérer le trafic, vous pouvez instituer un délai d’analyse. En général, la plupart des gens n'ont pas à s'inquiéter de cela. Les grands sites à fort trafic, cependant, peuvent vouloir expérimenter un peu.

Voici comment vous définissez un délai d'analyse de huit secondes:

Délai d'attente: 8C'est tout. Tous les moteurs de recherche n'obéiront pas à votre directive. Mais ça ne fait pas mal de demander. Comme pour les pages interdites, vous pouvez définir différents délais d'analyse pour des moteurs de recherche spécifiques..

Télécharger votre fichier robots.txt

Une fois que vous avez toutes les instructions dans votre fichier configuré, vous pouvez le télécharger sur votre site. Assurez-vous qu’il s’agit d’un fichier texte brut portant le nom robots.txt. Ensuite, chargez-le sur votre site pour pouvoir le trouver à yoursite.com/robots.txt..

Si vous utilisez un système de gestion de contenu 10 Systèmes de gestion de contenu en ligne les plus populaires 10 Systèmes de gestion de contenu en ligne les plus populaires en ligne L'époque des pages HTML codées à la main et de la maîtrise de CSS est révolue. Installez un système de gestion de contenu (CMS) et en quelques minutes, vous pourrez partager un site Web avec le monde entier. comme WordPress, il y a probablement une manière spécifique de s'y prendre. Comme il diffère d’un système de gestion de contenu à un autre, vous devez consulter la documentation de votre système..

Certains systèmes peuvent également disposer d'interfaces en ligne pour le téléchargement de votre fichier. Pour ceux-ci, il suffit de copier et coller le fichier que vous avez créé aux étapes précédentes.

N'oubliez pas de mettre à jour votre fichier

Le dernier conseil que je vais vous donner est de consulter occasionnellement votre fichier d'exclusion de robots. Votre site change et vous devrez peut-être faire des ajustements. Si vous remarquez un changement étrange dans le trafic de votre moteur de recherche, il est également judicieux de consulter le fichier. Il est également possible que la notation standard change à l'avenir. Comme tout le reste de votre site, il est conseillé de le consulter de temps en temps..

Quelles pages excluez-vous les robots d'exploration de votre site? Avez-vous remarqué une différence dans le trafic des moteurs de recherche? Partagez vos conseils et commentaires ci-dessous!